Forschende an der ETH Zürich entwickeln KI-Touchscreen mit Superauflösung

Forschende am Sensing, Interaction & Perception Lab haben CapContact entwickelt, eine KI-Lösung, mit der Touchscreens Berührungen mit achtmal höherer Auflösung erfassen als existierende Geräte.

Während die Bildschirme unserer Smartphones mit immer mehr Pixeln und brillanteren Farben weiterentwickelt wurden, hat sich der Berührungssensor, mit dem wir unseren Geräten Input geben, seit Jahrzehnten nicht verändert. Doktorand Paul Streli und Professor Christian Holz vom SIPLAB am Departement Informatik haben nun eine KI entwickelt, die den Touchscreens eine Superauflösung verleiht.

Herr Professor Holz, Herr Streli, Ihre Studie nutzt KI, um die Touchscreens, die wir tagtäglich benutzen, viel genauer zu machen. Wie kamen Sie auf die Idee?

Christian Holz: Der übliche Zweck von Touchscreens besteht darin, blosse (x,y)-Koordinaten von Berührungen zu liefern. Zuvor gingen wir darüber hinaus und erforschten die Verwendung von Touchscreens als Bildsensoren. Ein Touchscreen ist im Grunde genommen eine sehr niedrig auflösende Tiefenkamera, die nur etwa acht Millimeter weit sehen kann. Wir haben diese Fähigkeit unserer Handys genutzt, um Finger, Knöchel und Hände zu scannen und so Benutzer zu erkennen. Während dieses Projekts haben wir gemerkt, dass die wirkliche Herausforderung darin besteht, diejenigen Teile von Fingern und Händen zu erkennen, die tatsächlich in Kontakt mit der Oberfläche sind. Also haben wir versucht, beide Herausforderungen gleichzeitig zu lösen: die niedrige Auflösung dieser Sensoren und die genaue Erkennung von Kontaktflächen. Daraus entstand unser aktuelles Projekt, externe Seite CapContact.

Warum ist die Erkennung der tatsächlichen Kontaktflächen auf unseren Smartphones wichtig?

Christian Holz: Wenn man sich die Displays von Handys anschaut, bieten sie heute eine nie dagewesene visuelle Qualität. Und mit jeder neuen Generation von Handys konnten wir den Unterschied deutlich sehen: bessere Farbwiedergabe, höhere Auflösung, schärferer Kontrast. Was nur wenige Menschen wissen: Die Berührungssensoren in unseren Smartphones haben sich seit ihrer Markteinführung Mitte der 2000er-Jahre kaum weiterentwickelt. Schauen Sie sich zum Beispiel das neueste iPhone an: Es hat eine Displayauflösung von 2532x1170 Pixeln, aber der Berührungssensor selbst kann nur Eingaben mit einer Auflösung von etwa 32x15 Pixeln erkennen – das ist fast 80-mal niedriger als das, was wir auf dem Bildschirm sehen. Und da wundern wir uns, warum wir auf der kleinen Tastatur so viele Tippfehler machen? Wir glauben, dass wir Objekte durch Berührung pixelgenau auswählen können, aber das ist keineswegs der Fall.

«Handydisplays bieten heute eine nie dagewesene visuelle Qualität. Aber die Berührungssensoren in unseren Smartphones haben sich seit ihrer Markteinführung kaum weiterentwickelt.»Professor Christian Holz

Wie haben Sie die Touchfunktionalität verbessert?

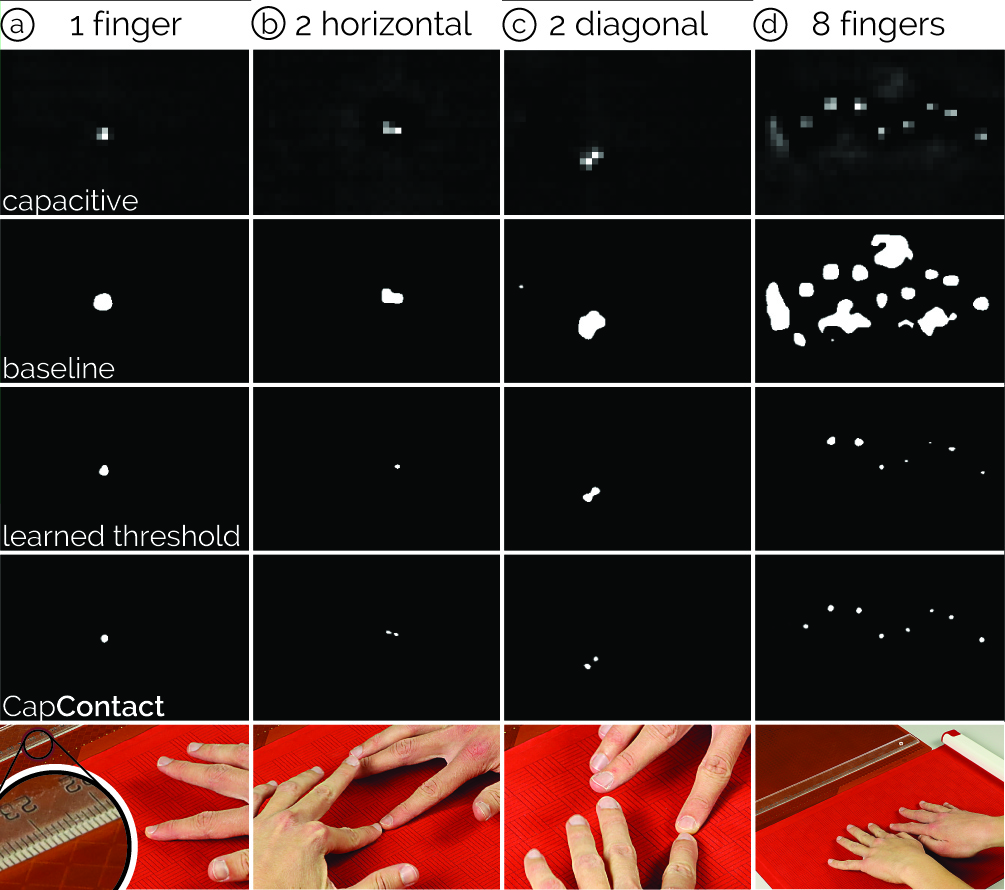

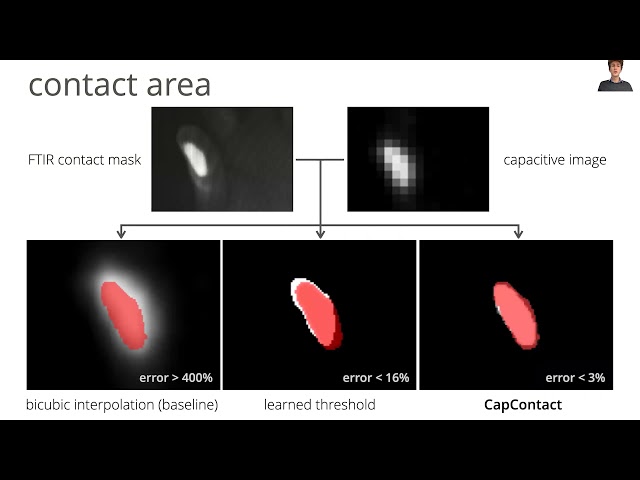

Christian Holz: Die Herausforderung besteht darin, dass diese Art von Berührungssensoren – die kapazitive Abtastung – nie dafür ausgelegt war, auf eine tatsächliche Berührung zu schliessen; sie entdeckt bloss die Annäherung unserer Finger. Aus diesen groben Nahbereichsmessungen interpolieren die heutigen Touchgeräte den Ort der Eingabe. Mit CapContact, unserer auf einem tiefen neuronalen Netzwerk basierenden Methode, überbrücken wir diese Lücke. Das hat zwei Vorteile: Erstens schätzt CapContact die tatsächlichen Kontaktflächen zwischen Fingern und Touchscreens bei Berührung. Zweitens generiert CapContact diese Kontaktflächen mit achtmal höherer Auflösung als die geringe Auflösung aktueller Berührungssensoren, wodurch unsere Touchgeräte Berührungen viel präziser erkennen können.

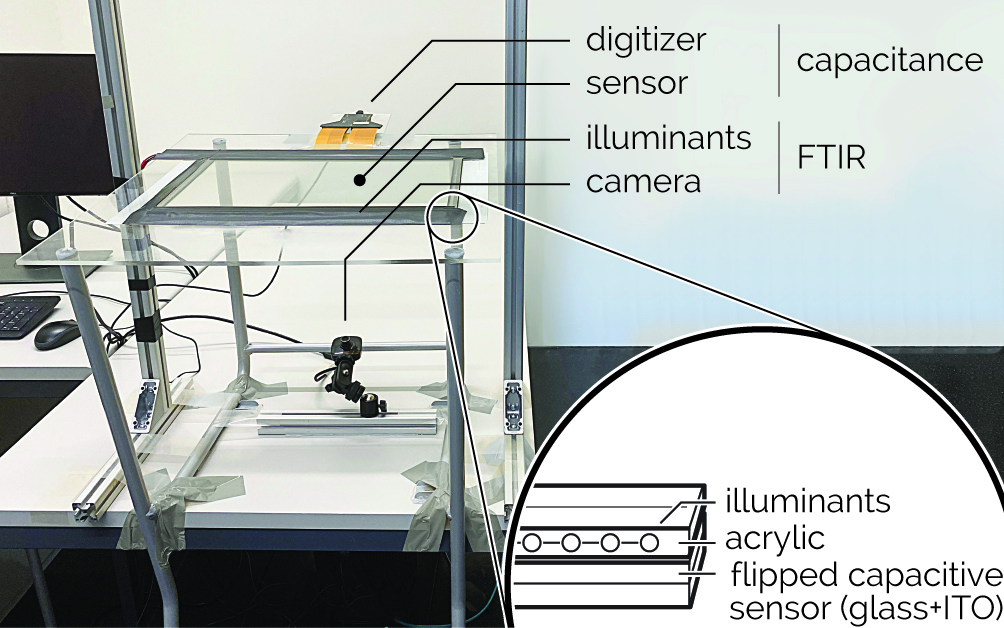

Um das neuronale Netzwerk von CapContact zu trainieren, haben wir ein eigenes Gerät entwickelt, das kapazitive Intensitäten und die tatsächlichen Kontaktkarten durch einen hochauflösenden Drucksensor integriert und aufzeichnet. Wir haben zahlreiche Berührungen von einer Reihe an Personen aufgenommen, um einen Datensatz zu erstellen. Daraus hat CapContact gelernt, superauflösende Kontaktmasken aus den groben, niedrig aufgelösten rohen Sensordaten heutiger Touchgeräte vorherzusagen. Nun kann CapContact diese superauflösende kapazitive Abtastung auf die Smartphones und Tablets der Konsumentinnen und Konsumenten bringen.

Wie profitieren die Nutzerinnen und Nutzer von dieser superauflösenden kapazitiven Abtastung?

Paul Streli: In unserem Paper zeigen wir, dass wir aus der Schätzung der Kontaktfläche zwischen Ihrem Finger und dem Bildschirm eines Smartphones durch CapContact die Position der Berührungseingabe mit höherer Genauigkeit ableiten können, als dies aktuelle Geräte vermögen. Tatsächlich zeigen wir, dass ein Drittel des Fehlers bei aktuellen Geräten auf die geringe Auflösung der Eingabeerkennung zurückzuführen ist. CapContact beseitigt diesen Teil des Fehlers durch unsere Deep-Learning-Implementierung, welche Hersteller mit einem Software-Update bereitstellen könnten. Wir zeigen auch, dass CapContact zuverlässig zwischen angrenzenden Berührungen unterscheiden kann, wo aktuelle Geräte versagen, z. B. bei einer Pinch-Geste, bei der Daumen und Zeigefinger nahe beieinander liegen.

Was ist der Vorteil für Gerätehersteller?

Paul Streli: Da wir gezeigt haben, dass CapContact die Berührungserkennung in Superauflösung möglich macht, haben wir ein Experiment mit einem noch niedriger auflösenden Sensor durchgeführt, um die Leistung von CapContact zu evaluieren. Anstelle der 32x15 Pixel auf Ihrem iPhone haben wir die Hälfte davon verwendet: 16x8, fast lächerlich niedrig. Trotzdem konnten wir zeigen, dass CapContact genauer Berührungen erkennt und Eingabeorte herleitet, als es aktuelle Geräte bei regulärer Sensorauflösung tun. Das zeigt, dass zukünftige Geräte mit unserer Methode die Komplexität der Sensoren und die Herstellungskosten in der Hardware einsparen und die fortschrittliche Signalverarbeitung von CapContact in der Software nutzen könnten, um trotzdem eine höhere Zuverlässigkeit und Genauigkeit zu liefern. Deshalb veröffentlichen wir das Modell und den Code als Open Source, zusammen mit dem Datensatz, den wir aufgezeichnet haben, damit die Community weiter daran forschen kann.

Was bräuchte es, damit CapContact auf den Markt kommt?

Christian Holz: Wir sehen eine Chance in der jüngsten Entwicklung von mobilen Geräten, die Neural Processing Units für maschinelles Lernen on device integrieren, z. B. in den neuesten iPhones und Android-Handys und -Tablets. CapContact sitzt zwischen der Sensorebene und der Anwendungsebene und diese neuronalen Prozessoren sind optimal geeignet, um CapContact auf die rohen Touchsignale anzuwenden. Das bietet Geräteherstellern die Möglichkeit, unsere Methode für bessere kapazitive Berührungseingabe und ein besseres Benutzererlebnis zu übernehmen.

Was sind die nächsten Schritte für das Projekt?

Christian Holz: Wir werden das Potenzial von CapContact in sehr niedrig auflösenden Touch-Sensing-Anwendungen weiter erforschen, da es viele Vorteile wie geringere Hardwarekomplexität und eine verbesserte User Experience bietet. Zum Beispiel haben wir CapContact auf Microsofts Project-Zanzibar-Gerät eingesetzt. Das ist eine 21 Zoll grosse, tragbare, flexible Matte, die die Interaktion mit Berührungen und greifbaren Objekten unterstützt und die einen viel niedriger auflösenden Sensor hat als aktuelle Smartphones. Mit CapContact bringen wir vollwertige, feingranulare Touchinteraktion auf solche Geräte mit einem grösseren Formfaktor, und wir erforschen jetzt die daraus resultierenden Möglichkeiten.

Übrigens sind wir immer daran interessiert, mit Studierenden zusammenzuarbeiten, die sich für die Integration von eingebetteten Geräten, maschinellem Lernen und interaktiven Benutzererlebnissen begeistern. Im Sensing, Interaction & Perception Lab erforschen wir die Schnittstelle zwischen Mensch und Technik und arbeiten an der Grenze zwischen Hardware- und Softwaresystemen. Für weitere Informationen besuchen Sie unsere externe Seite Website.